Ocena bezpieczeństwa rozwiązań wykorzystujących AI/ML

W dobie szybko zmieniającego się rynku cyfrowego istotnym jest dostarczanie klientom najlepszych produktów i usług. Właśnie dlatego firmy coraz częściej zaczynają wykorzystywać uczenie maszynowe i sztuczną inteligencję.

Szybki rozwój tych technologii sprawia jednak, że niemal codziennie pojawiają się nowe zagrożenia związane z bezpieczeństwem, w tym podatności związane z wykorzystaniem ML, AI, LLM i deepfake. Dla wielu firm pojawia się nowe wyzwanie – potrzeba wyprzedzenia incydentów i zapewnienia ochrony danych klientów.

Wraz z popularyzacją sztucznej inteligencji i uczenia maszynowego pojawiają się ważne pytania:

- Jak wdrożyć rozwiązanie wykorzystujące sztuczną inteligencję lub uczenie maszynowe przy jednoczesnym zapewnieniu bezpieczeństwa?

- Z jakimi aspektami bezpieczeństwa wiąże się integracja takich rozwiązań?

- Czy uda się dostrzec potencjalne zagrożenia?

Dlaczego warto wybrać ocenę bezpieczeństwa rozwiązań wykorzystujących AI/ML?

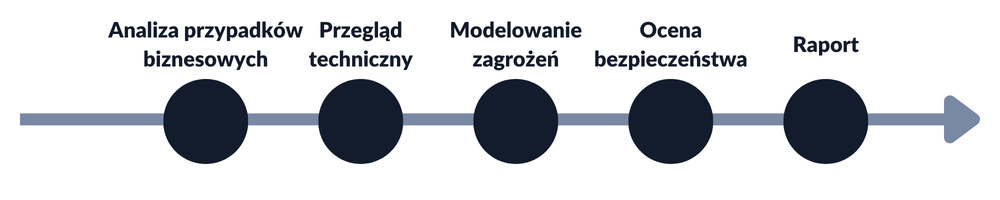

Jeśli zamierzasz wdrożyć sztuczną inteligencję lub uczenie maszynowe do swojej usługi lub produktu, warto rozważyć ocenę ich bezpieczeństwa. Nasza usługa oceny bezpieczeństwa rozwiązań wykorzystujących AI/ML obejmuje wszystko, od analizy przypadku biznesowego i identyfikacji zagrożeń po wykonanie przypadków testowych na wdrożonym rozwiązaniu.

Nasze podejście do oceny bezpieczeństwa rozwiązań wykorzystujących AI/ML

Analiza przypadków biznesowych AI/ML

Nasza współpraca zaczyna się od dogłębnego zrozumienia przypadku biznesowego, który przyczynił się do wdrożenia AI/ML. Dzięki temu możemy zidentyfikować zagrożenia biznesowe specyficzne dla Twojej firmy, zapewniając, że Twoja inwestycja w sztuczną inteligencję i uczenie maszynowe jest bezpieczna i korzystna.

Na tym etapie zadamy takie pytania:

- Jakie problemy biznesowe rozwiązujesz za pomocą AI/ML?

- Jakie zagrożenia biznesowe zidentyfikowałeś?

- Jakie są najgorsze możliwe zagrożenia związane z wykorzystaniem AI/ML w Twojej firmie?

Przegląd techniczny AI/ML

Następnie zagłębiamy się w szczegóły techniczne Twojego rozwiązania, analizując wszystko, od jego architektury po konkretne komponenty i usługi, z których korzystasz. Daje nam to kompleksowe zrozumienie systemu, co pozwala wykryć podatności i poprawić ogólny poziom bezpieczeństwa.

Na tym etapie zadamy pytania dotyczące:

- Danych, na których oparte jest rozwiązanie,

- Architektury komponentów zarówno w warstwie backendowej, jak i frontendowej,

- Zależności między komponentami rozwiązania,

- Sposobu integracji komponentów AI/ML z istniejącą architekturą,

- Podejścia w firmie do uwierzytelniania, autoryzacji i walidacji danych podczas interakcji z komponentami AI/ML.

Modelowanie zagrożeń AI/ML

Dzięki takiemu kompleksowemu zrozumieniu przeprowadzamy modelowanie zagrożeń AI/ML w celu zidentyfikowania problemów, które mogą mieć wpływ na Twoją aplikację lub platformę. Wykrywając te zagrożenia na wczesnym etapie, pomagamy uniknąć potencjalnych zakłóceń i zachować zaufanie klientów. Jeśli chcesz dowiedzieć się więcej o tym, jak przeprowadzamy modelowanie zagrożeń, przeczytaj ten artykuł.

Ocena bezpieczeństwa AI/ML

Po zidentyfikowaniu zagrożeń i ocenie ryzyka przeprowadzamy ocenę bezpieczeństwa AI/ML, aby ustalić, czy te kwestie mogą potencjalnie mieć wpływ na Twoje rozwiązanie. Takie podejście gwarantuje, że zagrożenia zostaną wyeliminowane, zanim zdążą wpłynąć na działalność firmy, i zapewni Twój spokój ducha.

Ze względu na to, że Twój projekt może być oparty na aplikacji internetowej lub mobilnej, zalecamy przetestowanie całego rozwiązania, a nie tylko komponentów AI/ML. Z naszego doświadczenia wynika, że końcowe raporty często ujawniają podatności w komponentach AI/ML, a także w API, aplikacji webowej lub aplikacji mobilnej, która integruje się z AI/ML.

Raport

Dzięki dogłębnej analizie z perspektywy biznesowej i technicznej oraz przeprowadzeniu dokładnego modelowania zagrożeń, zapewniamy, że nasza ocena bezpieczeństwa AI/ML i raport końcowy uwzględniają wszystkie zidentyfikowane zagrożenia. Otrzymujesz dokładną listę zidentyfikowanych podatności w kontekście zidentyfikowanych zagrożeń, wraz z oceną ich ryzyka oraz dostosowane, szczegółowe rekomendacje, które pomagają chronić Twoją firmę i zwiększać jej bezpieczeństwo.

Jak pracujemy – przykłady

Duży model językowy (LLM)

Jeśli w swoim rozwiązaniu używasz dużego modelu językowego (LLM) np. interaktywnego czata lub asystenta, ocenimy jego kilka kluczowych aspektów:

- Czy może dawać niepożądane odpowiedzi, takie jak przeklinanie lub wyśmiewanie (obejście walidacji)?

- Czy prompt może zostać zmieniony w celu uzyskania niepożądanych rezultatów, np. poprzez prompt injection lub techniki jailbreakowe, takie jak DAN (np. incydent w Air Canada)?

- Czy szczegóły dotyczące modelu źródłowego mogą zostać ujawnione? (kradzież modelu)

- Czy mechanizmy oparte na AI/ML wymagają znacznych zasobów obliczeniowych, które mogłyby wpłynąć na wydajność całej aplikacji internetowej/mobilnej, wydłużając czas ładowania strony i pogarszając komfort użytkowania?

Rozpoznawanie twarzy/biometria

Jeśli twoje rozwiązanie dotyczy kwestii rozróżniania prawdziwej osoby na zdjęciach/wideo od fałszywej, nasze pytania oceniające będą obejmować:

- Czy wybrano zestaw danych szkoleniowych, który zawiera odpowiednie informacje, bez wykluczania ze względu na płeć lub rasę?

- W jaki sposób rozwiązanie obsługuje różne formaty obrazu i wideo?

- Jakich metod używa rozwiązanie do kontroli żywotności?

- Jak rozwiązanie radzi sobie z obrazami z wieloma twarzami?

- Jak rozwiązanie radzi sobie z trudnościami takimi jak okulary, brody, różne fryzury itp.?

- Jak rozwiązanie radzi sobie z obrazami lub wideo niskiej jakości?

- W jaki sposób rozwiązanie przetwarza obrazy z wieloma warstwami?

- W jaki sposób rozwiązanie obsługuje animowane pliki GIF lub PNG?

- W jaki sposób rozwiązanie przechowuje dowody tożsamości (jeśli są potrzebne do weryfikacji)?

- Czy rozwiązanie wymaga weryfikacji ludzkiej, jeśli oprogramowanie zachowuje się błędnie?

Aby ocenić odporność modelu biometrycznego na potencjalne ataki, testujemy go za pomocą różnych scenariuszy. Obejmują one zarówno podstawowe tricki, jak i bardziej złożone przypadki testowe odzwierciedlające rzeczywiste zagrożenia. Co więcej, symulujemy przy użyciu technik AI/ML potencjalnych napastników, którzy próbują ominąć środki bezpieczeństwa za pomocą wygenerowanych przez AI próbek wideo lub audio ofiary.

Tutaj można znaleźć nasze artykuły dotyczące bezpieczeństwa biometrycznego:

- Before you implement Face Recognition to your app – AI hack study

- Voice Biometrics – how easy is it to hack them with AI Deepfake?

- Attacking the face recognition authentication – how easy is it to fool it?

Z odrobiną Twojej pomocy przeprowadzimy kompleksową ocenę bezpieczeństwa AI/ML. Wskaże to podatności i ich potencjalny wpływ na Twoją firmę. Rezultat? Wzmocniony system AI/ML i znaczne oszczędności kosztów. Proaktywne działania dzisiaj zmniejszają liczbę kosztownych poprawek jutro.

Dlaczego my?

Od ponad 20 lat Securing jest zaufanym partnerem w dziedzinie bezpieczeństwa IT. Nasz wysoko wyspecjalizowany zespół ma doświadczenie w różnych dziedzinach m.in. w web, mobile, cloud, embedded systems, IoT, AI/ML i blockchain. Naszym celem jest wykrywanie podatności, które mogą zostać wykorzystane przez hakerów. Skupiamy się na wczesnym wykrywaniu luk celem zwiększenia poziomu bezpieczeństwa.

Jako że bezpieczeństwo AI/ML jest nową i szybko rozwijającą się dziedziną, dokładamy wszelkich starań, aby być na bieżąco z nowymi rozwiązaniami, takimi jak OWASP TOP 10 Large Language Model Applications i MITRE Atlas. Dzięki temu skorzystasz z najnowszych informacji i najlepszych praktyk w zakresie bezpieczeństwa, zapewniając ochronę swojego rozwiązania również przed najnowszymi zagrożeniami.

Podczas oceny bezpieczeństwa AI/ML zapewniamy:

- Dogłębne zapoznanie się z Twoim przypadkiem biznesowym i szczegółami technicznymi,

- Identyfikację zagrożeń mających znaczenie dla sprawy,

- Szczegółowy raport z zaleceniami,

- Zespół z doświadczeniem w zakresie wykorzystania AI/ML i aspektów ich bezpieczeństwa.

Poza szeregiem ocen bezpieczeństwa AI/ML, nasi specjaliści znaleźli ponad 10 CVE związanych z AI/ML podczas bug bounties.

Zgodność z rozporządzeniem DORA

Ocena bezpieczeństwa rozwiązań wykorzystujących AI/ML pomaga zapewnić zgodność z rozporządzeniem DORA. Jest ona spójna z rekomendacjami DORA skupiającymi się na zarządzaniu ryzykiem.

Jak uzyskać wycenę projektu?

Wypełnij nasz formularz kontaktowy, zaznaczając, że jesteś zainteresowany oceną bezpieczeństwa rozwiązań wykorzystujących AI/ML. Wkrótce skontaktujemy się z Tobą i prześlemy naszą pełną ofertę.

Możesz również umówić się z nami na krótkie spotkanie, wybierając dogodną dla Ciebie godzinę w poniższym kalendarzu: